錦です。

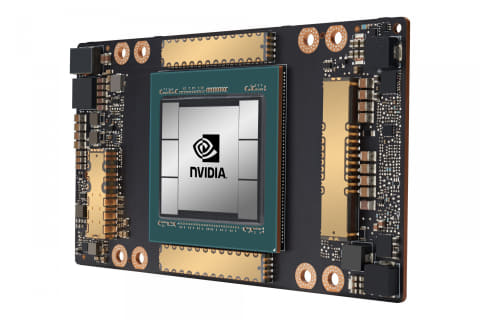

NVIDIAは、Ampereアーキテクチャを搭載する初のGPUである「NVIDIA A100」を発表しました。

NVIDIAは、YouTubeにてGTC 2020の基調講演の動画を8本投稿しています。

NVIDIA GTC 2020 Keynote - YouTube

A100

NVIDIA A100は、Ampereを基にした初のGPUで、AMDに遅れを取っていた7nmを採用したGPUです。データセンター向けのGPUで、Volta「V100」から20倍の性能を持ちます。

TSMC 7nmを採用し、トランジスタ数は驚異の540億。これはVoltaの2倍以上になり、dRAMはHBM2メモリで、インターフェイスは6,144bitになります。6つのHBMスタックをGPうに接続し、メモリ帯域は1.6TB/s、メモリ容量は40GBになっています。

SM数は108コア、FP32CUDAコア数は6,912コア、FP64CUDAコア数が3,456コアとなっており、FP32性能が19.5TFLOPS、FP64性能も9.7TFLOPSになっています。動作クロックはピーク時に1.4GHzに達するとのこと。

機械学習

A100は、機械学習専用のコアTensorコアを搭載しています。GPUはベクタ演算プロセッサですが、こちらはテンサー演算プロセッサであり、これらを組み合わせたハイブリット構成にすることにより、ディープラーニングの性能を飛躍させました。これは、Ampereアーキテクチャの進化にも繋がります。

A100にはTensorコアが1SMあたり4コア、計432コア搭載されています。AmpereとVoltaではTensorコアの数え方が変わり、Voltaでは16×16のテンサー演算ユニットが2コアとカウントされましたが、Ampereでは16×32のユニットとしてカウントされるため、表面上、SMあたりのTensorコア数が減ったように見えますが、実質そのままです。

AmpereのTensorコアでは、新たに「BFloat 16*1」と「Tensor Float32(TF32)」の2つのデータフォーマットが新たにサポートされました。

AmpereのTensorコアの大きな進化点としては、FP64(倍精度浮動小数点数)のサポートが追加されました。これは、ディープラーニングやHPCに向けた進化であり、HPCアプリケーションでは、19.5TFLOPSという性能になっています。これは、Voltaと比較して2.5倍の性能向上になっています。また、前述のTF32の実装によって、FP32(単精度浮動小数点数)演算でもVoltaの20倍 312TFLOPSの性能を実現しています。

8bit整数演算のディープラーニング性能はVoltaに対して20倍 1,248TOPSに達しています。

マルチ

マルチGPU模する個tができますが(後述)、A100を最大7つのGPUに分割し扱える「Multi Instance GPU(MIG)」という技術が実装され、様々な計算をそれぞれに割り当てる事もできます。

GPU間の接続がこれまでの2倍の帯域である600GB/s(ピーク時)に達する第3世代NVLinkをサポートしています。

DGX A100

A100を採用するスパコン向けのシステム、「DGX A100」は、A100 GPUを計8つ採用しており、CPUにAMDのRome CPU*2(64コア)を2ソケット採用し、FP16性能で5PFLOPSになります。また、計320GB HBM2メモリは12.4TB/sという驚異の帯域を持っています。DGX A100は199,000ドル(日本円約2,100万円)で出荷されます。

また、同じくAmpere GPUを採用したエッジ向けの機械学習向けAIプラットフォーム「EGX A100」も提供します。

Source:NVIDIA,PC Watch,PC Watch,VideoCardz